常见的神经网络激活函数

1. 激活函数需要满足的特点

(1) 连续并可导(允许少数点上不可导)的非线性函数. 可导的激活函数可以

直接利用数值优化的方法来学习网络参数.

(2) 激活函数及其导函数要尽可能的简单,有利于提高网络计算效率.

(3) 激活函数的导函数的值域要在一个合适的区间内,不能太大也不能太小,

否则会影响训练的效率和稳定性.

2. 常见的神经网络激活函数

2.1 SigMoid型函数

(1)Logistic函数

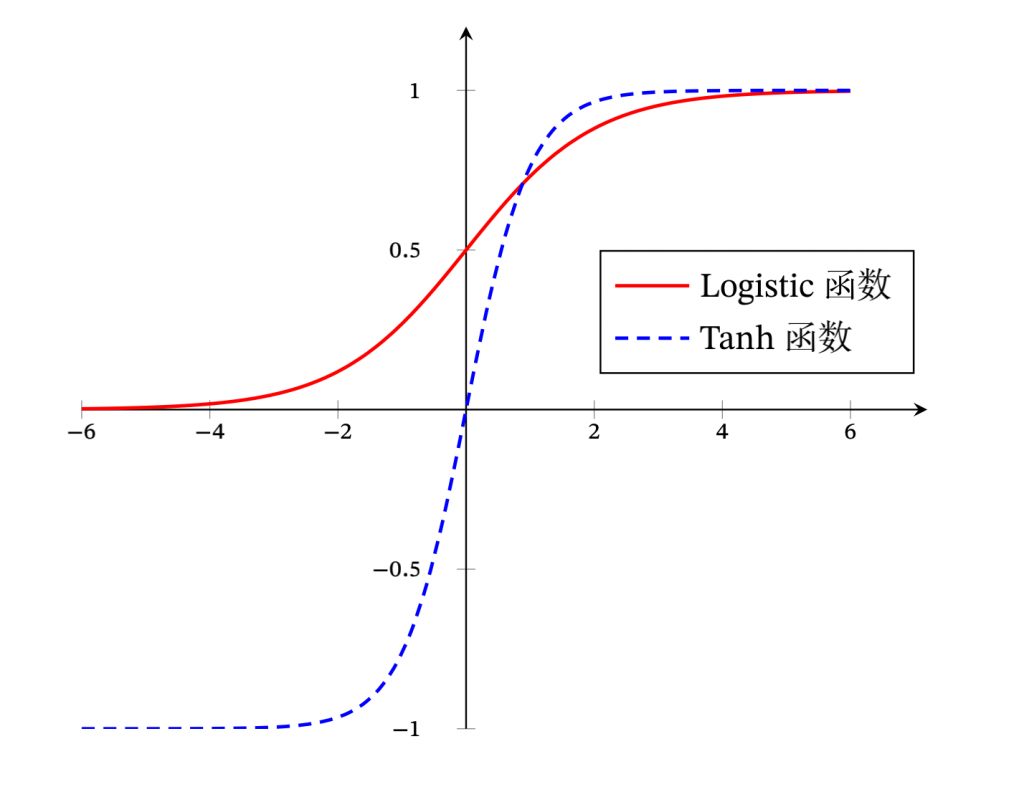

Logistic函数将输入值规划到(0,1)之间,输入数绝对值越大结果越接近于1,输入数绝对值值越小结果越接近于0。由于Logistic函数的结果范围性质,是的该函数的输出可以直接看做概率分布,是的神经网络可以与统计模型更好的结合,它也可以视为一个Soft Gate,用于控制其他神经元的输出信息数量。

(2)Tanh函数

Than函数的取值范围是(-1,1),Than可以看做是对Logistic函数的放大,可以表示为:tanh(?) = 2?(2?) − 1 ,Tanh函数的输出是零中心化 的(Zero-Centered),而 Logistic 函数的输出恒大于 0。非零中心化的输出会使得其后一层的神经元的输入发生偏置偏移(Bias Shift),并进一步使得梯度下降的收敛速度变慢。

阅读剩余

版权声明:

作者:姜九二

链接:https://www.jiangjianwu.cn/development/deep-learning/583/%e5%b8%b8%e8%a7%81%e7%9a%84%e7%a5%9e%e7%bb%8f%e7%bd%91%e7%bb%9c%e6%bf%80%e6%b4%bb%e5%87%bd%e6%95%b0.html

文章版权归作者所有,未经允许请勿转载。

THE END